L'un des points techniques de base les plus mal compris au cours de la dernière décennie est lié à la consommation d'énergie et à la façon dont les différents processeurs réagissent différemment à la charge. Le principe de base est que lorsqu'il y a un budget de puissance supplémentaire disponible, les cœurs individuels peuvent augmenter leur fréquence et leur tension pour maximiser les performances sur des échelles de temps courtes, en les réduisant lorsque davantage de cœurs sont nécessaires. La confusion vient de la façon dont cela fonctionne, entrelacé avec la façon dont TDP se rapporte à la consommation d'énergie. Après quelques discussions personnelles intéressantes au Computex, Intel Fellow Guy Therien, l'architecte en chef de la segmentation des performances des clients d'Intel, a accepté de rendre compte de la façon dont Intel a défini et adapté son explication du TDP et du Turbo, ainsi que de parler du nouveau maximiseur de performances d'Intel. outil d'overclocking. Nous couvrons également l'approche d'Intel sur le marché des passionnés.

Pour mettre cela en perspective : j'ai beaucoup de conversations chez Computex qui sont confidentielles, loin de la zone de présentation d'une entreprise respective. Il peut s'agir de discussions informelles avec mes contacts directs de relations publiques, de détails à venir ou de commentaires sur les activités de presse, ou de conversations plus approfondies en coulisses avec des ingénieurs. C'est la manière normale des choses - la plupart de ce que nous finissons par faire lors d'un salon professionnel n'arrive jamais à la publication, mais nous aide à fournir du contenu futur en comprenant la planification, le processus et le concept, même si nous ne pouvons pas faire de rapport direct événements. Mon objectif a toujours été d'aller au-delà de la boîte noire du fonctionnement de ces entreprises pour comprendre les relations internes et le fonctionnement, ne serait-ce que pour comprendre comment les décisions sont prises et quelles directions peuvent être indiquées ensuite.

Plusieurs de ces discussions cette année au Computex ont eu lieu avec Intel, principalement autour de ses démonstrations sur ses nouveaux processeurs 10 nm Ice Lake "10th Gen Core", ainsi que sur le Core i9-9900KS et le nouvel outil d'overclocking automatique Performance Maximizer d'Intel. En novembre, lorsque j'ai publié une analyse approfondie des raisons pour lesquelles les valeurs TDP et turbo d'Intel peuvent être quelque peu trompeuses pour la majorité des utilisateurs, Intel Fellow Guy Therien m'a contacté à l'époque pour m'aider à clarifier certaines choses. Nous avons eu quelques désaccords sur l'interprétation des valeurs, et cette discussion est revenue sur la base des annonces Computex d'Intel. Guy et moi avons eu des discussions profondes et intéressantes, dont certaines étaient purement d'un point de vue philosophique de l'expérience utilisateur.

Sur la base de ces discussions, Intel m'a invité à parler officiellement à Guy d'un certain nombre de ces points afin d'apporter des éclaircissements. Pour mémoire, j'aime parler à Guy - comme tout bon ingénieur, il est franc et direct, et est heureux d'avoir un débat houleux sur des sujets individuels. Cela ne veut pas dire que je suis allé doucement avec lui.

| |

Dr. Ian Curess

Rédacteur principal, AnandTech | Guy Therien

Chercheur corporatif, Intel |

Guy Therien est l'un de ces ingénieurs à vie d'Intel de longue date qui semblent rester dans les parages pendant des décennies. Il travaille dans l'entreprise depuis février 1993, évoluant à travers les différents rôles d'ingénierie de plate-forme jusqu'à ce qu'il soit nommé membre de l'entreprise en janvier 2018. Il détient 25 brevets américains, presque exclusivement dans les domaines des états de performance des processeurs, de la gestion de l'alimentation, de la gestion thermique, la migration des threads et l'allocation du budget d'alimentation. Guy a travaillé avec Intel pour adapter son utilisation du TDP sur les processeurs, et l'un de ses projets les plus récents a été d'identifier comment le TDP et le turbo devraient être implémentés et interprétés par les OEM et les partenaires de la carte mère. Parce que nous sommes maintenant dans une situation où les utilisateurs occasionnels voient la consommation d'énergie dépasser ce numéro TDP sur la boîte, même à des échelles de temps longues, c'est maintenant plus que les OEM qui doivent comprendre comment Intel définit ses spécifications. Guy occupe actuellement le poste de Corporate Fellow et d'architecte en chef pour la segmentation des performances au sein du groupe Client Computing d'Intel, contribuant au pipeline de leadership technique d'Intel.

Communauté

Ian Curess : Lorsque nous avons parlé au Computex, l'un des sujets que nous avons abordés concernait la relation d'Intel avec la communauté des passionnés et son évolution. au cours des 10 à 15 dernières années. Nous avons traversé le bon vieux temps de la haute performance et de la poussée des overclocks, jusqu'à maintenant où nous avons eu plusieurs générations de produits similaires. Nous sommes maintenant de retour dans une guerre complète sur x86 entre Intel et AMD. De votre point de vue, en tant qu'architecte en chef au sein d'Intel, comment Intel aborde-t-il la communauté en ce qui concerne sa pile de produits ces jours-ci ?

Guy Therien : Vous savez donc qu'historiquement, une chose intéressante s'est produite : nous avions de nombreux produits sur l'ensemble de notre gamme SKU et ils étaient utilisés à des fins différentes par différentes personnes. Mais ensuite, nous avons découvert qu'il y avait un certain sous-ensemble de ces personnes, ce que nous appelons maintenant les overclockeurs et les passionnés, qui voulaient tirer le meilleur parti des produits. Comme vous le savez, le fait d'être une grande entreprise implique en partie que lorsque nous fabriquons des millions et des millions de produits, nous devons appliquer certaines exigences pour nous assurer que nos employés qui ne sont pas passionnés (c'est-à-dire la majorité de la clientèle d'Intel) obtiennent ce qu'ils attendent de nos produits en termes de performances et de fiabilité, de durée de vie, etc.

Ainsi, en raison de ces exigences de qualité de nos produits, nous imposons des contrôles et des limites aux performances des pièces, même s'il est en fait possible d'atteindre momentanément des performances supérieures. Les passionnés d'aujourd'hui sont prêts à prendre des risques et ne considèrent peut-être pas les performances d'usure ciblées pour la population générale, et ils ont donc commencé, vous savez, à faire de l'overclocking et à modifier le fonctionnement du processeur en dehors de l'ensemble de contrôle standard d'Intel, en utilisant des contrôles qui sont en dehors du fonctionnement du processeur lui-même, des choses comme BCLK et l'augmentation des vitesses de mémoire et des vitesses d'horloge. Pendant longtemps, nous avons pensé "hé, ça va être mauvais" et nous avons usé le processeur et vous savez qu'il y avait des problèmes internes concernant les personnes qui faisaient cela. Je dirais qu'à l'époque, il y avait un soulagement général que les gens qui faisaient cela n'épuisaient pas les processeurs. Mais au fil du temps, une transition intéressante s'est produite où nous avons réalisé qu'il y avait une grande partie des gens qui voulaient vraiment faire ça. Toutes les choses s'additionnent au fil du temps pour créer ces produits.

Donc, l'idée s'est en fait transformée en essayant d'empêcher les gens de changer leurs horloges externes pour piloter ces contrôles internes au processeur afin de les rendre plus uniformes de plusieurs façons. Maintenant, bien sûr, comme vous le savez, nous avons des contrôles internes et une capacité d'overclocking et donc si vous êtes prêt à accepter les risques de modifier la valeur par défaut au-delà des ratios standard fournis avec les processeurs K SKU, vous pouvez déverrouiller le multiplicateur et vous pouvez définir les ratios par programme et programmer réellement les ratios pour augmenter leurs performances. Bien sûr, il y a parfois un inconvénient à cela, ce qui signifie que cela ne durera pas aussi longtemps.

Donc, si vous pensez peut-être à la communauté des passionnés d'aujourd'hui, comment notre point de vue a évolué : il est passé de nous considérer comme un défi pour la qualité de nos produits, à un atout. Vous savez, nous fabriquons beaucoup de produits, et nous voulons vraiment garder la capacité maximale des produits, puis en ouvrant et en adoptant ces contrôles de manière publique, nous avons pu fournir des performances supplémentaires aux personnes qui en ont vraiment besoin. le ou le veux.

Ian Curess : Nous avons donc demandé à Intel de faire beaucoup de matériel promotionnel au cours des dernières années en ce qui concerne les passionnés. Selon vous, quel est l'état des relations avec les passionnés aujourd'hui au sein d'Intel ? Comment Intel voit-il les passionnés aujourd'hui ? Quelle est la force de la volonté de mettre le matériel de performance entre les mains de ces passionnés ?

Guy Therien : Eh bien, nous nous concentrons certainement sur les passionnés. Vous avez entendu parler de nos efforts de création de PC, et toute notre gamme K SKU est orientée à la fois vers les personnes qui sont des passionnés qui sont des consommateurs, mais aussi ce que l'on pourrait appeler des passionnés professionnels qui ont vraiment besoin de tirer le meilleur parti de la performance de leur entreprise. Donc, aujourd'hui, nous sommes entièrement derrière le côté des passionnés avec des produits d'overclocking et nous poussons continuellement des boutons d'overclocking supplémentaires dans nos produits. C'est ainsi que de maximiser les performances que vous avez vues dans le 9900K et le 9900KS, ce que nous appelons des trucs `` minces '', en fait, dans certains cas, vous savez qu'il y a des pièces spécialisées ou à faible volume vendues par le biais d'un processus d'enchères, pour les gens à tirer plus de performances des processeurs avec le plus grand nombre de cœurs. C'est donc une reconnaissance très forte et directe de l'accent mis sur la fabrication de produits qui répondent aux besoins des passionnés en les comprenant et en proposant des produits à bacs minces pour les soutenir.

Ian Curess : Diriez-vous qu'Intel aborde les passionnés et les overclockeurs comme des groupes différents ?

Guy Therien : Il y a ceux que nous appelons les overclockeurs qui vont exécuter et travailler en dehors des spécifications. Nous acceptons les [opérations] hors spécifications si vous en acceptez les risques inhérents. Les passionnés, en revanche, sont des gens qui ont besoin de performances et nous essayons de maximiser les performances « conformes aux spécifications » pour les passionnés. Certes, il y a un fort croisement et il y a des passionnés prêts à accepter les risques de l'overclocking, donc il y a certainement un mélange entre les deux. Mais nous nous concentrons également sur les opérations « conformes aux spécifications » ainsi que sur la possibilité de sortir des spécifications. Personnellement, j'essaie de maximiser les performances « conformes aux spécifications », comme le i9-9900KS, comme le W-3175X, mais vous pouvez sortir des spécifications et en obtenir encore plus.

Intel Performance Maximizer

Ian Curess : L'une des choses dont nous avons discuté au Computex concernait le nouvel outil Intel Performance Maximizer et la possibilité de sortir des spécifications performance. Ce nouvel outil redémarre le PC dans un mode UEFI personnalisé, teste le processeur et fournit un overclock. Intel veut le mettre à la disposition des personnes qui ne sont pas nécessairement d'accord avec le fonctionnement de ces outils d'overclocking. Je sais que vous avez fait beaucoup de travail en ce qui concerne cet outil - pouvez-vous me parler de la réflexion en interne sur la façon dont Intel est passé de l'attitude "rester dans les spécifications", à la conception de l'outil précédent Intel XTU, pour avoir maintenant le L'outil Intel Performance Maximizer (IPM) et les groupes de personnes ciblés ?

Guy Therien : Donc, pour donner un peu de contexte à cela. Mon histoire est dans le logiciel, puis je me suis lancé dans la gestion de l'alimentation et finalement les interactions processeur-OS pour contrôler les fonctionnalités du processeur. J'étais donc l'un des responsables de Speed Step, et les états P matériels étaient également mon projet. Puis, au fil du temps, tout en cherchant à améliorer le turbo, j'ai commencé à rechercher ce que nous pouvions faire de plus. C'est à ce moment-là que j'ai commencé à regarder comment tous les cœurs du package ne sont pas créés égaux, et j'ai commencé à regarder comment certains cœurs ont la même tension mais produisent une fréquence plus élevée à cette tension. Cela a finalement conduit à Turbo Boost Max, mais en cours de route, j'ai dû en apprendre beaucoup sur la fabrication et la fiabilité. Cela a finalement conduit un jour à des discussions avec des entreprises qui overclockent des systèmes commerciaux - elles nous achètent des processeurs et les testent et absorbent la garantie elles-mêmes et vendent leurs systèmes aux clients des services financiers et les soutiennent.

Donc, grâce à tous ces efforts, nous avons également rencontré un problème intéressant qui se produisait côté serveur. Lorsque nous vendons nos pièces, en ce qui concerne nos outils internes, nous faisons une modélisation pour déterminer leur durée de vie prévue. Il existe une expression mathématique d'usure qui est notre spécification. Cette spécification est basée sur l'usure projetée du processeur et sur le temps que nous pensons que les pièces typiques ou les pièces les plus défavorables (ou les plus utilisées) passeront en turbo. Nos fiches techniques internes précisent le pourcentage de pièces qui devraient durer un certain temps avec quelle charge de travail. Ainsi, nos utilisateurs comprennent cela, ils achèteront nos pièces (nous parlons des serveurs vraiment haut de gamme), et ils diront qu'ils comprennent qu'il y a une limite à leur durée de vie lorsqu'ils sont utilisés dans les conditions Intel a précisé - mais qu'ils ne l'utiliseront pas dans ces conditions. Ils nous demandent que s'ils le mettent en turbo et le laissent en turbo, 24 heures sur 24, 7 jours sur 7, combien de temps cela va-t-il durer ? Ils nous regardent, ils comprennent ce que nous vendons et à quel prix, mais ils nous demandent combien de temps nos produits durent dans leurs conditions spécifiques. Lorsque cela a commencé à se produire, nous avons dit que nous ne savions pas, mais nous allions essayer de comprendre.

Un effort a donc été entrepris pour essayer de mesurer l'usure de ces systèmes. Juste pour être clair, tous les systèmes s'usent lentement et deviennent plus lents / ont besoin d'une tension plus élevée pour la même fréquence au fil du temps. Ce que nous faisons, comme tout le monde dans l'industrie, c'est ajouter une certaine tension, une marge d'usure, pour garantir que la pièce continue de fonctionner conformément aux spécifications pendant une durée de vie spécifique de la pièce. Ainsi, vous pouvez mesurer la tension dont les pièces ont besoin à mesure qu'elles s'usent au fil du temps et, espérons-le, déterminer quand les pièces s'usent (si elles s'usent du tout, car certaines ne s'usent pas beaucoup du tout). Ils voulaient savoir si nous pouvions évaluer cela hors ligne et leur donner un indicateur du moment où une pièce allait s'user. Il s'est avéré qu'il y avait un long effort pour essayer de le faire. Comme la disponibilité du serveur doit être en hausse comme 99,999% du temps, le projet a finalement échoué. Nous avions des faux positifs et des faux négatifs et nous ne pouvions pas leur dire exactement quand chaque pièce spécifique allait s'user, et quand nous leur avons dit qu'elle n'allait pas s'user, c'est finalement le cas. C'est donc une tâche très difficile, n'est-ce pas? J'ai donc pris connaissance de cet effort, et l'une des révélations que l'équipe a eues était que, pour améliorer leur précision, ils ne pouvaient pas prendre de mesures pendant qu'un système d'exploitation fonctionnait, en raison de la variabilité causée par le système d'exploitation, en raison d'interruptions et d'autres arrière-plans processus, ils ont donc appris à effectuer les mesures dans un environnement hors ligne en dehors du système d'exploitation.

Nous avons donc tiré cette conclusion et nous avons examiné de nombreux autres utilitaires qui disaient qu'ils avaient des fonctionnalités d'overclocking automatique et des capacités de réglage automatique. Beaucoup de ces utilitaires n'ont pas eu beaucoup de succès, principalement en raison de la variabilité de la durée d'exécution à l'intérieur du système d'exploitation, et aussi parce qu'ils inclinent souvent les choses au maximum, ce qui, avec le temps, en raison de l'usure, signifie que les paramètres ne sont pas applicables/don' ne fonctionne plus. Ces utilitaires ne reviennent jamais en arrière et évaluent à nouveau la situation pour voir s'ils doivent reculer un peu, ou ajouter un peu plus de tension, ou quelque chose, afin de maintenir le fonctionnement du système. Donc, sans données réelles indiquant que beaucoup de gens qui achètent le meilleur processeur n'overclockent pas, nous soupçonnions que c'était effectivement vrai. Nous avons supposé que la grande partie de ces clients qui achètent nos produits haut de gamme veulent des performances maximales mais ne surchargent pas même s'ils ont la capacité avec le SKU K. L'idée était donc, en examinant ce que nous pouvons faire manuellement avec des outils compliqués comme XTU ou le BIOS, où vous devez ajuster de nombreux paramètres pour overclocker, nous avons vu que la capacité interne de la plupart des processeurs était en moyenne largement supérieure à la spécification. Ce n'est pas comme si c'était un ou deux bacs au-dessus de la spécification, c'était souvent parfois quatre ou cinq bacs. Nous avons donc pensé que nous devrions fournir un moyen pour les gens qui achètent le meilleur d'être en mesure d'obtenir un peu plus de performances de la pièce qu'ils ont achetée.

Maintenant, parce qu'il y a une certaine variabilité dans les pièces, et parmi les millions de pièces que nous créons, certaines sont bien meilleures que d'autres en termes de capacité maximale. Mais certainement la majorité d'entre eux, la part du lion d'entre eux, peuvent atteindre au moins plusieurs bacs (1 bac = 100 MHz) au-dessus des spécifications sans trop de risques pour le fonctionnement quotidien.

Le résultat de tout cela est que nous avons réfléchi à la raison pour laquelle les personnes qui achètent les meilleurs processeurs, les processeurs K, n'overclockent pas. Parce que ça peut faire peur, non ? Avec tous ces paramètres, tels que l'augmentation des limites de courant, l'augmentation des tensions, le changement de puissance et la manière dont tous ces paramètres interagissent, et qu'en est-il de l'overclocking de la mémoire, etc. Nous avons donc adopté une approche plus simpliste pour l'utilisateur, en nous concentrant uniquement sur l'overclocking du ratio, offrant un moyen facile pour l'utilisateur final de le faire en quelques clics avec notre nouvel outil Intel Performance Maximizer (IPM). Si l'utilisateur accepte les conditions [d'utilisation], cela devient une expérience très facile. Donc, pour beaucoup de gens qui ont acheté les meilleures pièces, il devient maintenant assez facile d'obtenir un peu plus de performances, jusqu'à 10-15 %, ce qui dépendra de la qualité du processeur, mais c'est le chemin à elle.

En fin de compte, cet outil IPM s'adresse à tous ceux qui achètent un processeur K et acceptent un petit risque lors de l'exécution hors spécifications en échange de plus de performances du produit qu'ils ont déjà acheté.

Ian Curess : Quelle est la position d'Intel vis-à-vis de l'overclocking sur les ordinateurs portables, par rapport aux ordinateurs de bureau et aux stations de travail ? Ou ces types d'appareils sont-ils considérés comme indépendants en interne, pour les types d'utilisateurs qui pourraient être intéressés par l'optimisation des performances de leur matériel dans les différents segments de marché.

Guy Therien : Quel que soit l'appareil, si vous achetez le SKU haut de gamme qui est déverrouillé, nous voulons faire savoir à ces gens qu'ils peuvent obtenir un peu plus de performances de manière simple et manière simple avec l'outil IPM dans les processeurs de bureau, tant qu'ils acceptent le risque.

Ian Curess : Vous avez mentionné d'autres outils d'overclocking qui existent déjà, et qu'Intel est unique en ce sens que vous avez la possibilité d'optimiser les overclocks en dehors du système d'exploitation. Nous voyons des outils comme Asus, MSI, ASRock et d'autres partenaires majeurs d'Intel, qui ont construit des outils au cours de la majeure partie des 10 dernières années. Qu'est-ce que l'IPM peut apporter à la table que ces gars-là ne peuvent pas ?

Guy Therien : Donc, le premier est la simplicité et la facilité d'utilisation. Nous sommes convaincus que de nombreux outils existants sont écrasants pour la majorité des utilisateurs et qu'il n'y a qu'une petite partie des utilisateurs qui sont prêts à essayer de comprendre et d'apprendre toutes les nuances des outils.

Le second est le niveau de fiabilité qui accompagne le fait de ne pas aller jusqu'au bout et d'avoir quelques marges. IPM sélectionne 100 MHz en dessous de la fréquence de passage de crête. C'est un outil qui permet aux utilisateurs de fonctionner en continu sans aucune crainte en poussant l'overclocking trop haut. Avec IPM, nous pensons qu'il est certainement plus stable que les autres outils - nous apportons un niveau de fiabilité que les autres outils n'apportent pas, en ajoutant des marges et en ne poussant pas jusqu'aux limites de chaque processeur.

Une autre caractéristique de l'IPM est que lorsque les autres utilitaires sont utilisés, ils définissent une série de paramètres tels que la fréquence et la tension, puis effectuent un test de résistance pour voir s'il fonctionne. Si cela se bloque, ils reculent et réessayent, puis reculent et réessayent, et qui sait quels choix individuels l'utilisateur a au niveau du test de résistance. Je veux dire, bien sûr, il y a toujours eu des réglages automatiques dans les applications tierces, mais cela se résume toujours au test de résistance - certains utilisateurs disent que Prime95 est un bon test de résistance, mais de notre côté de la clôture, nous devons couvrir un large gamme de contraintes pour toutes les choses qui pourraient mal tourner lors de l'augmentation de la vitesse au-delà des spécifications. Ainsi, IPM a un ensemble spécial de tests qu'il exécute et que nous avons conçus en interne pour fournir ce que nous pensons être un bon ensemble de couverture pour tous les cas critiques de l'ensemble du système qui pourraient être affectés par une fréquence élevée, tels que les cas critiques et chemins de calcul non critiques. Ainsi, avec nos tests intensifs, plus la marge supplémentaire que nous fournissons, vous savez que le système devrait être très performant avec une bonne stabilité. Parce que nous connaissons le processeur comme nous, personne d'autre ne peut égaler la façon dont nous testons.

TDP et Turbo : ce qu'ils signifient et comment nous devrions tester

Ian Curess : IPM s'adresse aux personnes qui souhaitent overclocker ou tirer le maximum de leur processeur. Mais la plupart des passionnés veulent simplement utiliser un processeur prêt à l'emploi tout en ayant les meilleures performances - dans cet esprit, ils s'appuient sur des spécifications telles que les cotes TDP d'Intel et les fréquences turbo. Pouvez-vous expliquer la relation d'Intel avec la façon dont il définit TDP et Turbo, et les raisons derrière ces définitions ?

Guy Therien : il y a quelques années, j'étais chargé d'affiner le langage pour m'assurer que nous avions des termes descriptifs dans toute l'entreprise pour ce qu'est TDP et ce qu'est Turbo. Cela était basé sur un certain nombre de personnes qui se réunissaient et parlaient de la façon dont nous testions nos pièces et de ce que nous appliquions réellement en termes de TDP.

Le TDP est une dissipation de puissance moyenne à une limite de température de fonctionnement de jonction maximale, spécifiée dans la fiche technique d'Intel pour ce processeur, pour laquelle le processeur est validé lors de la fabrication et lors de l'exécution d'une charge de travail associée à haute complexité spécifiée par Intel à cette fréquence. Cela signifie que lorsque nous citons une fréquence de base, nous pensons à un environnement dans le pire des cas et à une charge de travail réelle à haute complexité qu'un utilisateur mettrait sur la plate-forme - lorsque la pièce est exécutée à une certaine température, nous promettons que chaque pièce vous obtiendrez atteindra cette fréquence de base dans la puissance TDP. C'est donc de cela qu'il s'agit - cela permet à nos clients, à nos clients ODM et aux fabricants de savoir quelle capacité thermique et capacité de fourniture d'énergie mettre en œuvre dans leurs systèmes afin qu'ils obtiennent la fréquence de base, que nous avons peut-être historiquement appelée notre fréquence "marquée".

Pour cette charge de travail de référence, nous devons également faire face à la complexité de cette charge de travail. Si vous prenez deux charges de travail, comme une simple boucle de rotation 100 % "pas de travail mais tout en gardant tout sous tension" qui provoque un turbo, et une charge de travail complexe à 100 %, la différence de consommation d'énergie entre les deux peut être de plusieurs dizaines de watts. Si nous définissons un virus de puissance comme quelque chose qui fait basculer chaque transistor et chaque porte sur chaque horloge, le n considère le pire des cas de virus de puissance absolu - notre charge de travail TDP n'est pas cela. Nous définissons TDP avec une charge de travail qui est un pourcentage de ce scénario du pire cas (un pourcentage élevé, mais pas 100 %), car vous vous approchez rarement du pire virus de puissance absolu dans des conditions réelles (même avec un rendu vidéo). Ce pourcentage peut changer en fonction de la génération du processeur, en fonction des capacités de chaque processeur, de la probabilité d'utilisation de diverses parties du processeur à mesure que les charges de travail évoluent. Nous pouvons ajuster notre charge de travail pour qu'elle corresponde n'importe où, de cette boucle de rotation de base au virus de puissance et tout entre, ou même deux ensembles de charges de travail simultanément. Nous devons faire toute cette analyse pour essayer de comprendre ce que nous pensons dans une génération donnée est une charge de travail typique dans le pire des cas, en particulier avec toutes les applications logicielles existantes. Par exemple, un streamer de jeu peut exécuter 87 % de notre charge de travail prévue ou quelque chose comme ça, afin qu'il puisse profiter d'une consommation d'énergie inférieure à la fréquence de base ou obtenir une fréquence supérieure à la base dans la plage turbo - peut-être même la fréquence turbo maximale pour une longue période de temps.

Il y a aussi la variabilité naturelle de la fabrication des pièces. Certains siliciums ont plus de chance que d'autres. N'oubliez pas que lorsque nous spécifions TDP, c'est pour toutes les pièces que vous achèterez jamais. Donc, si vous êtes un OEM et que vous achetez un million de processeurs, nous spécifions que chaque pièce que vous achetez, aucune d'entre elles ne dépassera nos cotes. Mais en raison de la variabilité de la fabrication, souvent, les pièces que vous obtenez sont loin d'être proches du pire des cas. Parfois, nous fabriquons les pièces dans un casier spécifique, et parfois nous les regroupons, pour des raisons telles que la demande ou les demandes. C'est pourquoi il y a des sociétés tierces qui entrent, achètent un tas de pièces, les testent, déterminent celles qui fonctionnent le mieux et revendent les pièces les plus rapides. Pour eux, il s'agit simplement de profiter de la variation naturelle de la fabrication.

Ian Curess : Donc, ce que j'entends, c'est que lorsqu'Intel sort une nouvelle pièce, j'aurais besoin de plus de 10 échantillons pour pouvoir vérifier la variabilité moi-même ?

Guy Therien : Quand il s'agit d'échantillons de presse, je ne m'en charge pas ! (rires) Mais ce que nous pouvons dire chez Intel, c'est qu'au fur et à mesure que nous créons plus de processeurs, nous comprenons et améliorons le processus de fabrication. Nous pouvons examiner la fuite d'un processeur et voir où elle se situe dans la gamme projetée de tous les millions de pièces que nous avons fabriquées. Nos données sont généralement très précises, même si au départ, il peut y avoir des prédictions au fur et à mesure qu'une partie devient plus mature. Avec certaines premières parties, en particulier des choses comme des échantillons d'ingénierie qui ne sont de toute façon pas vendus aux utilisateurs finaux, nous sommes encore en train de peaufiner le processus et de le préparer. Mais lorsque nous sommes prêts à fournir des processeurs à examiner, ce sont les mêmes que les processeurs de vente au détail, car nous ne voulons pas déformer le marché.

Ian Curess : L'une des choses dont nous avons parlé dans le passé concerne le fonctionnement du TDP et du turbo et le fonctionnement des budgets turbo. Mon argument est qu'il n'est pas nécessairement clair pour le grand public comment Intel corrèle ces valeurs avec les masses. Je me demandais si vous vouliez nous donner un bref aperçu.

Guy Thérien : Bien sûr. Le concept général est donc que nous avons des limites de fréquence - chaque fois qu'un cœur est actif, de sorte que chaque processeur a une fréquence turbo à un ou deux cœurs que nous publions. Au-delà, selon le nombre de cœurs actifs, nous avons une limite maximale sur la fréquence. Mais pour cette limite du système, c'est une limite de fréquence, et ce que nous finissons vraiment par faire, c'est appliquer le TDP. Le TDP est une puissance moyenne qui est forcée au fil du temps. C'est important ; il ne s'agit pas seulement d'une valeur singulière. En conséquence, ce que le turbo fait vraiment, c'est contrôler la puissance plutôt que la fréquence.

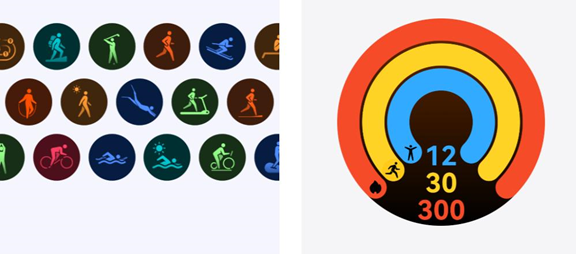

Dans un processeur, nous définissons une limite de puissance en rafale, que nous appelons Power Limit 2 (PL2), par rapport au TDP, qui est Power Limit 1 (PL1). Il existe un algorithme exécuté dans le processeur qui garantit que le TDP, sur une période de temps, est appliqué en tant que puissance moyenne. L'algorithme n'est pas une simple moyenne mobile, mais une moyenne mobile pondérée exponentielle, ce qui signifie que la consommation d'énergie la plus récente compte le plus - c'est un algorithme standard.

Mais cela signifie que si vous avez été inactif pendant un certain temps, vous disposez d'un budget d'alimentation spécifié. Un processeur peut utiliser de la puissance, jusqu'à sa limite de puissance PL2 et sa limite de fréquence, jusqu'à épuisement du budget, puis le processeur se déplacera pour apporter la valeur moyenne de puissance PL1/TDP. C'est comme une baignoire qui se remplit d'eau - si vous la videz, vous ne pouvez en vider qu'une quantité suffisante avant de devoir la remplir à nouveau.

Cette limite PL2 et le budget de puissance sont configurables. En fait, sur toutes les parties client, vous pouvez configurer à la fois la période pendant laquelle le TDP est appliqué et la hauteur de la limite de puissance à laquelle vous pouvez éclater. Vous souvenez-vous d'avoir parlé de la complexité de la charge de travail ? Eh bien, il s'avère que si vous exécutez une charge de travail simple, vous obtiendrez peut-être toute la fréquence turbo possible, mais comme la charge de travail est légère, vous n'épuisez pas tellement le budget de puissance et pouvez turbo à cette fréquence élevée pour plus long. C'est le budget de puissance qui est finalement appliqué. Mais une charge de travail plus complexe peut exploser, atteindre PL2 et épuiser une grande partie de ce budget très rapidement, de sorte que vous êtes tout d'un coup hors budget. Dans ce cas, en interne, nous réduirons la fréquence pour maintenir le processeur dans la limite de puissance à long terme (PL1 / TDP) jusqu'à ce que vous puissiez retrouver le budget selon l'algorithme mentionné précédemment.

Donc, si nous considérons un système au repos, cela a un budget de puissance complet. Au fur et à mesure que la charge de travail arrive sur les cœurs, les algorithmes de temps pondérés internes vous pompent jusqu'à la fréquence la plus élevée tant qu'elle est disponible pour le nombre de cœurs actifs. Ensuite, nous regarderons la puissance consommée, et tant qu'elle est inférieure à votre limite de puissance PL2, vous êtes bon. Nous continuons donc à cette fréquence. Lorsque l'algorithme de moyenne mobile pondérée exponentielle commence à calculer et voit la puissance qui est dissipée / maintenue. Puis, après un certain temps, il regarde le temps pendant lequel il doit appliquer cette puissance moyenne, que nous appelons Tau (τ). Lorsque Tau est atteint, l'algorithme se déclenche et voit s'il doit réduire la puissance consommée, afin qu'il puisse rester dans la limite de TDP. Cela signifie que vous obtenez une explosion de performances à l'avant. Une fois que cette performance, ce budget de puissance, est épuisée, le processeur commencera à réduire la puissance en interne en réduisant la fréquence pour s'assurer que le TDP est appliqué tout au long de sa configuration. Tau est donc la chronologie sur laquelle TDP est appliqué par l'algorithme.

PL2 et Tau sont tous deux configurables par l'OEM et l'ODM, et sont « conformes aux spécifications ». Vous avez donc la possibilité, bien sûr, si la puissance délivrée prend en charge une limite de puissance supérieure, et aussi si le système a la capacité thermique (car cela n'a aucun sens si vous allez simplement accélérer thermiquement), d'ajuster ces valeurs. Les fabricants de cartes mères et les ODM investissent donc dans leurs solutions d'alimentation et thermiques pour leur permettre de maximiser les performances ou d'obtenir une certaine durée de turbo sans étranglement - dans la mesure du possible. En conséquence, vous pouvez investir différentes sommes d'argent dans la fourniture d'énergie, la solution thermique, la finesse du système, etc. - c'est la capacité de concevoir quelque chose qui se différencie pour le public, à la fois en termes de facteur de forme et performance.

La chose à retenir est que vous pouvez concevoir un système exagéré pour de nombreux environnements - au-delà de ce qui est généralement requis dans le cadre d'une utilisation normale. Si une charge de travail est appliquée à un processeur de 65 W et à un processeur de 95 W, et qu'ils explosent tous les deux jusqu'au même 200 W, et se terminent avant que l'algorithme de contrôle turbo ne soit appliqué, c'est ainsi que les OEM et les fabricants peuvent se différencier dans leur conception. Cela signifie que si les deux processeurs ont les mêmes paramètres de fréquence turbo, ils obtiendront le même score chez Cinebench, même avec une différence de TDP de 30 W. Pour les systèmes mobiles, il s'agit de la capacité de refroidissement limitée du système que vous touchez, et du fait que la tête ne passe peut-être pas et devient inconfortable au toucher. Pour un ordinateur de bureau, le problème est peut-être l'acoustique ou la température de l'air du ventilateur d'extraction. Mais un partenaire peut clairement concevoir un système pour avoir une fenêtre turbo de trois minutes sur laquelle le TDP est appliqué. Ainsi, en fonction de la capacité du système, nous avons le TDP, puis les paramètres Turbo associés (PL2 et Tau) peuvent être configurés pour répondre à la capacité du système.

Ian Curess : L'une des choses que nous avons constatées avec les pièces que nous examinons est que nous prenons des cartes mères grand public ou de station de travail telles qu'ASUS, ASRock et tels, et ils implémentent leurs propres valeurs pour cette limite PL2 ainsi que la fenêtre turbo - ils pourraient pousser ces valeurs jusqu'au maximum qu'ils peuvent atteindre, comme une limite (maximale) de 999 W pendant 4096 secondes. À votre avis, cela déforme-t-il la façon dont nous effectuons les évaluations, car cela signifie nécessairement qu'ils manquent de spécifications définies par Intel ?

Guy Therien : Même avec ces valeurs, vous n'êtes pas à court de spécifications, je tiens à être très clair : vous utilisez les spécifications, mais vous obtenez une durée de turbo plus longue.

Nous allons être très précis dans notre définition de la différence entre conforme et hors spécification. Il y a un 'bit'/drapeau d'overclocking sur nos processeurs. Toute modification nécessitant que vous définissiez ce bit d'overclocking pour activer l'overclocking est considérée comme une opération hors spécifications. Donc, si le fabricant de la carte mère laisse un processeur avec ses valeurs turbo habituelles, mais indique que la limite de puissance est de 999 W, cela ne nécessite pas de changement du bit d'overclocking, il est donc conforme aux spécifications.

Ian Curess : La question devient alors : comment Intel préférerait-il que nous testions les avis ?

Guy Therien : Permettez-moi de réfléchir un peu avec vous à ce sujet. Si vous envisagez un i9-9900K et l'une des cartes mères d'overclocking les plus haut de gamme. Ce fabricant de cartes mères va dire qu'ils se différencient, ils pourraient mettre un million de phases sur le VRM, ils pourraient supposer que vous allez refroidir le CPU par liquide, et donc ils mettent leurs paramètres par défaut pour prendre en charge la puissance maximale le peut se dissiper - même s'il s'agit d'une puissance maximale "illimitée" de facto. Ils commenceront en fait à le couper si le processeur consomme plus que ce qui est possible. Ils permettent la différenciation en ajustant les capacités de la carte, puis les paramètres, mais toujours conformes aux spécifications, jusqu'à ce que vous renversiez ce bit d'overclock. Ensuite, il y aura peut-être un autre groupe de personnes qui construiront non pas une carte d'overclocking, mais une carte pour passionnés de jeux ou un système d'entreprise. Ces utilisateurs peuvent toujours vouloir le meilleur processeur i7 ou i9, même s'il s'agit d'un processeur K, car ils veulent les meilleures performances conformes aux spécifications.

Vous devez donc vous demander comment vous allez revoir les capacités d'un processeur comme le i9-9900K. Je l'examinerais dans une carte mère du haut, quelque chose au milieu et une conception budgétaire, ou la conception la moins chère / la plus rentable, pour montrer comment elle peut être configurée. Ensuite, vous pouvez dire que dans les différentes conceptions, cela fonctionnera comme les fabricants de cartes mères ont conçu les systèmes.

Mais alors la question devient aussi celle des repères. Quelque chose comme TouchXPRT ou SYSMark vous donnera de bonnes durées de rafale, car les charges de travail sur ces tests ne consomment pas beaucoup de puissance. Mais quelque chose comme Cinebench peut être trompeur, car avec un bon système, il peut potentiellement fonctionner entièrement dans la fenêtre de rafale turbo configurée. Vous devez être prudent lorsque vous regardez et mesurez quelque chose comme Cinebench. C'est l'une des raisons pour lesquelles nous ne sommes pas favorables à l'utilisation de cela comme référence pertinente.

Ian Curess : Alors, comment Intel travaille-t-il avec ses partenaires du côté des ordinateurs portables en ce qui concerne les valeurs turbo et les valeurs de la fenêtre turbo ?

Guy Therien : C'est une histoire intéressante qui n'est pas que rose. J'ai participé à la définition et à la création de turbo, et donc spécifiquement les ordinateurs portables étaient là où nous essayions d'obtenir toutes les performances possibles, et nous avons reconnu qu'il y avait une période de temps pendant laquelle nous pouvions fonctionner au-dessus de la fréquence de base avec turbo , et offrent des avantages en matière de performances en rafale. Nous nous sommes donc demandé à quelles valeurs ce turbo devait-il être réglé. Lorsque nous avons examiné le problème pour la première fois il y a de nombreuses années, nous avons examiné ces ordinateurs portables et nous avons examiné leur épaisseur, la rapidité avec laquelle les thermiques se propageraient de l'endroit où se trouve le processeur jusqu'au clavier et au repose-mains, quelle était la taille de l'échangeur de chaleur, et des trucs comme ça. On en a fait une analyse complète, parce que l'idée c'était qu'on ne voulait pas dire quelque chose comme "voilà la fréquence turbo, elle est vraiment haute, tu ne l'auras jamais". Ce serait idiot de dire, de donner des chiffres qui ne pourraient être possibles que pendant un dixième de seconde - nous voulions donner des données réalistes.

Nous avons pris du recul pour examiner la situation dans son ensemble, sur la façon dont nous dériverions les valeurs turbo. Il y a eu un long effort pour examiner un tas de charges de travail sur une courbe de complexité et de puissance, pour essayer de comprendre à quoi ces valeurs PL2 et Tau devraient être configurées compte tenu du temps qu'il faudrait à l'ordinateur pour chauffer. Ces valeurs peuvent être supérieures ou inférieures à ce que l'ODM pourrait ressentir comme une température appropriée pour le repose-mains, ou le bruit du ventilateur, ou la température d'échappement. Il a donc été réglé pour s'assurer que la période de ce que vous avez obtenu avec le turbo était telle que vous n'avez pas étranglé. Le PL2 et le Tau d'origine étaient réglés pour un turbo d'environ 28 secondes sur mobile.

Au départ, malheureusement, nous ne sommes pas revenus pour nous recentrer sur ce point année après année, pour nous assurer que ces valeurs étaient continuellement mises à jour avec la façon dont les conceptions mobiles modernes étaient abordées, ce qui a rétrospectivement eu un impact sur les implémentations optimales. Nous fournissons désormais des mises à jour d'une année sur l'autre des défauts internes alors que nous continuons à fournir plus de performances génération après génération. À l'avenir, nos partenaires et nos clients se concentreront encore plus sur la définition des paramètres par défaut et sur la garantie qu'il n'y a pas d'étranglement thermique tout en pouvant profiter du turbo.

L'avenir

Ian Curess : Comment voyez-vous l'évolution d'Intel, comment rapporte-t-il TDP et Turbo à l'avenir ? Avez-vous des idées sur la façon dont Intel l'aborde à partir d'ici, sur son engagement du turbo et sur son évolution ?

Guy Therien : nous nous efforcerons de fournir des fonctionnalités dont nous pensons que les utilisateurs peuvent tirer parti. Ainsi, comme nous l'avons mentionné lors du discours d'ouverture de Computex, dans l'espace HEDT avec de nombreux cœurs, nous étendrons nos définitions de Turbo Boost Max à plus d'un seul cœur, à plus de deux cœurs, au fur et à mesure que cela deviendra approprié. Comme vous pouvez l'imaginer, à mesure que le nombre de cœurs augmente, la question devient alors de savoir quand avez-vous besoin de tous ces cœurs, et quand n'en avez-vous besoin que de quelques-uns et pouvez profiter d'une marge supplémentaire.

Mais c'est une sorte de va-et-vient, en particulier avec des choses comme les jeux ; la part du lion des consoles est constituée de huit cœurs, vous ne verrez donc pas nécessairement les jeux dépasser huit cœurs, car ils ne sont pas très utiles. . Les développeurs de jeux devront décider où ils vont mettre leurs efforts. Cela dit, nous avons vu ce que vous pourriez appeler le nombre idéal de cœurs pour les jeux, entre quatre et huit, et donc à l'avenir, vous nous verrez concentrer nos efforts sur l'optimisation de la fréquence et des performances dans ce domaine.

Je pense avoir mentionné dans un blog d'Intel à un moment donné que, quel que soit le nombre de cœurs dont les gens ont besoin, avec la demande de l'application pour à la fois tirer parti et fournir des avantages avec autant de cœurs, nous effectuons l'analyse tout le temps avec respect aux logiciels exécutés simultanément, comment ils évoluent avec le nombre de cœurs, etc. Donc, pour l'instant, quatre cœurs sont le point idéal pour la plupart des consommateurs, avec quatre à huit pour les jeux. Au-delà de cela, plusieurs choses s'exécutent simultanément, car les applications individuelles n'ont pas tendance à évoluer aussi haut, à moins que vous ne passiez à HEDT. Nous continuerons donc à chercher à fournir des capacités telles que Turbo et Turbo Boost Max pour le nombre idéal de cœurs dont nous pensons que les gens peuvent tirer le meilleur parti, et bien sûr, nous envisagerons de déplacer cela dans d'autres segments de CPU au-delà de HEDT. au fil du temps.

Ian Curess : Une chose qu'Intel et AMD font différemment est qu'Intel fournit des tables turbo spécifiques pour les fréquences turbo sur le nombre de cœurs actifs, tandis qu'AMD adopte une approche plus axée sur la puissance dans laquelle et augmente les cœurs en fonction de la quantité de table de budget d'alimentation restant dans le système. Étant donné que vous comprenez les mérites des deux implémentations, pouvez-vous dire pourquoi les recommandations d'Intel sont meilleures par rapport à ce qu'offre AMD, ou donner un aperçu des différentes approches de votre point de vue ?

Guy Therien : Je ne peux donc vraiment parler que du fonctionnement de l'implémentation d'Intel, mais je voudrais souligner que nos tables turbo concernent davantage les limites de fréquence absolues ; il y a toujours un budget de puissance élément de l'équation, et ces valeurs ne sont que les valeurs maximales, mais elles sont toujours basées sur la puissance.

Vous vous demandez peut-être pourquoi nous ne laissons pas simplement la fréquence « flotter » ou la fréquence de tous les cœurs, si la puissance le permet. Il s'agit d'une discussion sur les techniques, et je ne dis pas laquelle est la meilleure, mais je vais vous donner deux raisons pour lesquelles nos tables turbo existent comme elles le font.

Le premier concerne le fait que vous avez une grande diversité de types d'instructions, comme AVX, qui peuvent soudainement être présentées sur un processeur. Vous devez être capable de réagir très rapidement aux changements dans le mélange d'instructions du processeur, en d'autres termes, aux changements dans la consommation d'énergie d'un cœur afin d'assurer un fonctionnement continu, sinon vous obtiendrez une chute de tension et potentiellement une panne (selon sur la proximité de la tension par rapport à un état de panne, ce qui est lié à la consommation d'énergie si une marge supplémentaire est ajoutée). Nous appliquons donc ces états de puissance sur la frontière d'entrée/sortie de l'état C. Ce n'est pas un sondage périodique pour voir ce qui se passe ici et peut-être faire quelques changements - chaque fois qu'un cœur change son état C, la puissance et les limites changent en fonction du nombre de cœurs actifs, ce qui garantit la fiabilité. Il y a un certain conservatisme inhérent à cela, mais comme vous le savez, la qualité et la régularité sont rois. Ainsi, nos tables turbo sont généralement définies assez haut, et nous nous assurons que les instructions gourmandes en énergie comme AVX réagissent à un ensemble de règles différent, avec des règles encore plus importantes pour les instructions AVX plus volumineuses au-delà des instructions standard. Mais en raison de la grande variation de puissance entre cette boucle simple et la charge de travail de virus de puissance la plus complexe (et/ou la charge de travail TDP), il y a un conservatisme que nous appliquons pour assurer la qualité et le fonctionnement, et c'est pourquoi, comme le nombre de cœurs qui sont des augmentations actives, nous abaissons les limites de fréquence, ce qui protège le cœur des défaillances. Maintenant, vous pourriez voir certains de nos produits qui ne marchent pas en escalier, ils gardent en fait tout à la même fréquence - c'est parce que ce sont des pièces blindées spéciales où nous savons que nous pouvons maintenir la fréquence en fonction des caractéristiques du silicium de cette partie. Mais lorsque vous en fabriquez des millions et des millions, il existe une variété de caractéristiques matérielles que vous apprenez, et nous avons mis en place des contrôles pour assurer un fonctionnement fiable pour toutes les pièces que nous vendons.

La deuxième raison est la séparation des SKU. Nous avons une gamme de produits et nous spécifions chacun exactement pour une fiabilité à long terme et un fonctionnement continu, avec des fréquences opérationnelles prédéfinies comme l'exigent certains de nos plus gros clients pour la cohérence et la prévisibilité, fournissant des paramètres de fréquence maximaux pour les clients qui en ont besoin.

La troisième raison est que nous devons nous assurer que nos pièces durent longtemps. Si la première raison est de faire en sorte que les pièces ne meurent pas à cause d'une tension soudaine, la deuxième raison est que nous sommes très attentifs à examiner la durée de vie des pièces et à nous assurer que lorsque vous achetez une pièce Intel, en moyenne, elle dure un certain temps. durée de vie cible. Personne ne veut être le fabricant chez qui vous achetez où dès que la garantie est épuisée, la pièce meurt le lendemain - nous voulons nous assurer que nous sommes ceux qui ont un fonctionnement fiable et durable. Donc, de ce point de vue, nous avons nos objectifs d'usure qui ont nécessairement un impact sur ces valeurs pour assurer un fonctionnement continu. Nous devons également tenir compte de la manière dont les différents clients utilisent les pièces tout au long de leur durée de vie, en particulier avec des performances toujours élevées sur le matériel. Ainsi, d'autres fabricants de processeurs peuvent avoir des objectifs de qualité différents des nôtres.

Un grand merci à Intel PR et à Guy pour leur temps. Un grand merci également à Gavin Bonshor pour la transcription.

Lecture connexe