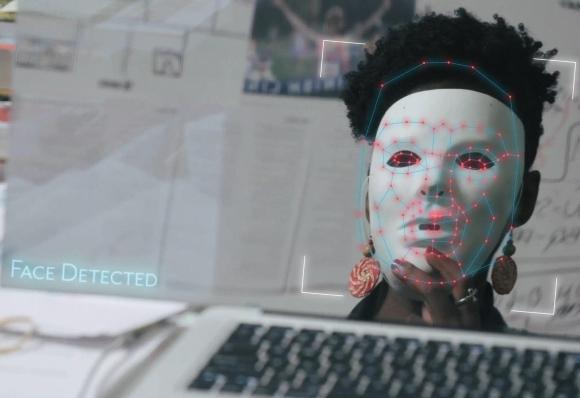

J'ai appris pour la première fois sur l'IA et les biais en 2016 de mon étudiant de maîtrise Joy Buolamwini.Elle construisait un «miroir magique» numérique qui mélangeait l'image de son visage avec celui de l'un de ses héros, Serena Williams.Pour que le projet fonctionne, un algorithme nécessaire pour identifier les traits du visage de Joy afin qu'il puisse cartographier ses yeux, son nez et sa bouche à l'image générée par ordinateur de l'étoile de tennis.

Dans une joie vidéo faite, l'algorithme a identifié immédiatement les traits du visage de son collègue asiatique-américain.Face au visage plus sombre de Joy, il a complètement échoué.Puis Joy a mis un masque blanc sans affaire et l'algorithme est entré en action.C'était une démonstration profonde de la façon dont le vrai visage de Joy était entièrement invisible pour un algorithme qui pouvait identifier un visage caricatural, tant qu'il était blanc.

La vidéo de Buolamwini s'est transformée en un audit influent des préjugés raciaux et de genre des systèmes de vision machine, une thèse de doctorat et finalement l'Algorithmic Justice League, une organisation de défense des défenseurs axée sur l'équité dans l'intelligence artificielle.Et cela m'a envoyé sur le chemin de la prise en compte des problèmes techniques qui pourraient être résolus avec de meilleures données, et lesquelles nous obligent à construire de meilleures sociétés.

L'algorithme que la joie des tests était mieux pour détecter les visages plus légers que les plus sombres car il avait été formé sur de nombreux visages pâles et moins de mélanine riches en mélanine.Ce n'était probablement pas une décision consciente: au lieu de cela, les créateurs de ces algorithmes ont travaillé avec des ensembles de données existants comme «Faces étiquetées dans la nature», un ensemble d'images collectées à partir d'articles de presse publiés en ligne.Cet ensemble est de 78% de sexe masculin et de 84% blanc, reflétant les préjugés sociétaux sur ce qui compte comme des nouvelles et qui devient célèbre.En formant des systèmes de reconnaissance faciale sur ces ensembles de données, les créateurs de ces algorithmes ont fini par intégrer des biais sur qui est important et digne d'intérêt dans leur système.

Le problème identifié par la joie est réparable: les entreprises peuvent recycler les modèles d'IA sur un ensemble de visages plus riche, y compris plus de femmes et plus de personnes de couleur.IBM a répondu aux critiques des préjugés dans ses algorithmes, en partie en créant un nouvel ensemble de données en utilisant l'imagerie de Bollywood Films.Dans une tentative incroyablement problématique de résolution de problèmes, Google aurait envoyé des entrepreneurs dans les grandes villes américaines pour capturer des images de sans-abri à la peau sombre en échange de cartes-cadeaux Starbucks de 5 $.À condition que de meilleures données, ces modèles fournissent de meilleurs résultats sur les visages plus sombres.

La journaliste technologique pionnière Julia Angwin a dirigé une équipe qui a enquêté sur un problème de biais algorithmique très différent.Le comté de Broward, en Floride, utilise un système algorithmique appelé Compas pour calculer les «scores de risque» pour les défendeurs criminels.Le score de risque estime la probabilité qu'un individu commetra un autre crime, les juges de l'information peuvent utiliser pour prendre des décisions concernant la libération d'un accusé sous caution ou la délivrance d'une peine de prison.

L'équipe d'Angwin a comparé les évaluations des risques du système avec le casier judiciaire réel des individus afin de démontrer que le système était deux fois plus susceptible de signaler à tort les défendeurs noirs que les futurs criminels et plus susceptibles de mal préparer les défendeurs blancs comme un risque à faible risque.

Comme pour le biais dans la vision par ordinateur, les mauvaises performances de l'algorithme Compas sont un problème de données.Mais c'est un problème beaucoup plus difficile à résoudre.La raison pour laquelle Compas prédit que les Noirs américains sont plus susceptibles d'être arrêtés à nouveau est que les Noirs américains sont cinq fois plus susceptibles d'être arrêtés pour un crime que les Américains blancs.Cela ne signifie pas nécessairement que les Noirs américains sont plus susceptibles de commettre des crimes que les Américains d'autres races - les Américains noirs et blancs ont des taux de consommation de drogues similaires, mais des taux d'arrestation extrêmement disparates pour les délits de drogue, par exemple.Compas ne peut pas prédire le risque pénal équitable parce que la police en Amérique est si injuste pour les Américains noirs.

Certains des systèmes d'IA les plus impressionnants apprennent en utilisant une sorte de «voyage dans le temps» dans leurs calculs.Mozziyar Etemadi à la Northwestern University School of Medicine a développé un algorithme d'IA qui détecte les tumeurs pulmonaires sur des tomodensitogrammes avec une précision de 94%, tandis que les radiologues expérimentés détectent seulement 65%.Le système d'Etemadi est si bon car il peut examiner un scan précoce d'une tumeur, pris des années avant la détection d'un cancer, et le comparer à un an plus tard une fois que la tumeur est visible, apprenant les signes d'alerte précoce d'un cancer imminent.Cela ne s'améliore pas pour classer les images de tumeurs à un stade précoce - il «triche» en apprenant également des images de mûres, il sait donc ce qui s'avérera bénin et qui sont malins.

La méthode de voyage dans le temps ne résout pas le problème de l'algorithme Compas.Nous pouvons examiner les prédictions compas pour savoir si une personne est susceptible d'être arrêtée à l'avenir et collecter des données sur l'exactitude de ces prédictions.Comme Angwin, nous pouvons voir que le système surédit la probabilité que les hommes noirs soient arrêtés.Mais même si nous recyclons le système en fonction de ces nouvelles données, nous faisons toujours des préjugés, car les hommes noirs en Amérique sont tout simplement plus susceptibles d'être arrêtés pour les mêmes crimes que les hommes blancs.

Pour corriger l'algorithme de Compas, vous devrez corriger les données raciales sur lesquelles elle a été formée avec une forte dose de données d'arrestation des communautés américaines qui ne subissent pas d'injustice raciale, autant que l'amélioration des algorithmes de reconnaissance faciale avec des données faciales plus diverses.Cela conduit à un défi important pour les développeurs des systèmes d'IA.Première étape: mettre fin à l'injustice raciale entre les communautés.Deuxième étape: collecter des données.Troisième étape: recyclez vos algorithmes.

Les problèmes que Buolamwini et Angwin ont identifiés ont contribué à engendrer une nouvelle branche de la recherche sur l'IA appelée FACCT - raies, responsabilité et transparence.FACCT Les chercheurs s'affrontent contre des vérités mathématiques complexes: il est impossible de réduire certains types d'erreur d'IA sans augmenter la probabilité d'autres.Mais les problèmes de biais intégrés dans l'IA suggèrent des leçons en dehors de l'informatique.

Les systèmes d'IA extrapolent du comportement humain.Nous enseignons aux machines comment traduire en regardant des livres disponibles, disons, hongrois et anglais.Le hongrois est une langue neutre du genre - le pronom ő peut signifier «lui, elle ou ça."Mais quand une peine hongroise dit" ő est une infirmière ", la plupart des traductions machine rendent" elle est infirmière ", tandis que" ő est médecin "est traduit par« il est médecin."Ce n'est pas la décision consciente d'un programmeur sexiste - c'est le produit de centaines d'années pour supposer que les femmes sont des infirmières et des hommes sont des médecins.Grâce à la pression des chercheurs FACCT, des entreprises comme Google réparent leurs algorithmes pour être moins sexiste.Mais peut-être que le travail le plus important que les chercheurs des chercheurs peuvent faire est de nous montrer ce que les biais sociaux sont codés dans nos modèles à partir de types de discrimination qui sont si omniprésents que nous avons simplement appris à vivre avec eux.

Les entreprises du monde entier remplacent les humains coûteux et sujets aux erreurs par des systèmes d'IA.Au mieux, ces systèmes surpassent les humains les mieux formés.Mais souvent, ils échouent de manière cohérente qui révèle le sexisme, le racisme et d'autres préjugés systémiques de notre société.Nous devons travailler pour nous assurer que ces systèmes biaisés ne refusent pas injustement la caution des défendeurs noirs.Mais nous devrions travailler encore plus dur pour créer une société où les Noirs ne sont pas arrêtés à des taux injustement élevés.

Les systèmes AI calcifient les biais systémiques dans le code.C'est pourquoi il est si important de les interroger et d'empêcher les algorithmes biaisés de nuire aux personnes mal équipées pour défier les décisions opaques, apparemment oraculaires prises par des algorithmes informatiques.

Mais les problèmes que l'IA a avec les biais peut servir de feuille de route à partir de certains des problèmes les plus pernicieux et ancrés de la société.Et si notre réponse au biais dans l'IA n'était pas seulement pour réparer les ordinateurs, mais la société qui les forme?