Commentaire : les mesures de protection de l'enfance d'Apple suscitent des réactions mitigées de la part des experts

Ben Lovejoy

- 6 août 2021 6h12 PT

@benlovejoy

0

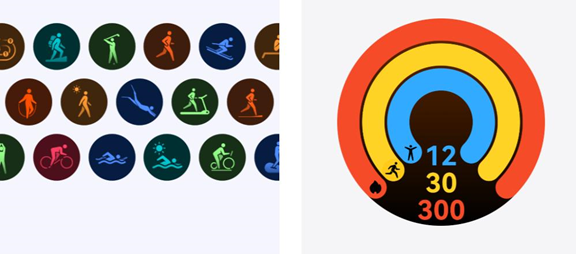

L'annonce hier de

Les mesures de protection des enfants d'Apple

confirmé

un rapport antérieur

que la société commencerait à rechercher des photos d'enfants maltraités sur les iPhones. La nouvelle a suscité des réactions mitigées de la part des experts en cybersécurité et en sécurité des enfants.

Quatre préoccupations avaient déjà été soulevées

avant que les détails ne soient connus, et l'annonce d'Apple concernait deux d'entre eux…

Problèmes d'analyse CSAM

Les préoccupations initiales comprenaient le fait que les signatures numériques pour le matériel d'abus sexuel d'enfants (CSAM) sont délibérément floues, pour permettre des choses comme des recadrages et d'autres ajustements d'image. Cela crée un risque de faux positifs, que ce soit par hasard (concerne un) ou par action malveillante (souci 2).

Apple y a répondu en annonçant que l'action ne serait pas déclenchée par une seule image correspondante. Ceux qui collectent de tels documents ont tendance à avoir plusieurs images, Apple a donc déclaré qu'un certain seuil serait requis avant qu'un rapport ne soit généré. La société n'a pas révélé le seuil, mais a déclaré qu'elle réduisait les risques de faux positif à moins d'un sur mille milliards. Personnellement, cela me satisfait complètement.

Cependant, deux autres risques subsistent.

L'Electronic Frontier Foundation (EFF)

a souligné le risque d'abus

, soulignant qu'il n'y a aucun moyen pour Apple ou les utilisateurs de vérifier les empreintes digitales. Un gouvernement peut

raconter

Apple qu'il ne contient que des hachages CSAM, mais il n'y a aucun moyen pour la société de le vérifier.

À l'heure actuelle, le processus est qu'Apple examinera manuellement les images signalées, et ce n'est que si l'examen confirme des contenus abusifs que l'entreprise transmettra les détails aux forces de l'ordre. Mais encore une fois, rien ne garantit que l'entreprise sera autorisée à continuer à suivre ce processus.

Universitaire de cryptographie Matthew Green

réitéré ce point

après ses tweets de pré-annonce.

L'EFF dit

c'est plus qu'un risque théorique :

A Hong Kong, par exemple,

critique du gouvernement chinois

est classé au même niveau que le terrorisme, et est passible de la réclusion à perpétuité.

Problèmes d'analyse d'iMessage

Des inquiétudes ont également été exprimées quant à l'analyse que les iPhones basés sur l'IA effectueront sur les photos dans iMessage. Cette analyse ne repose pas sur des signatures numériques, mais essaie plutôt d'identifier les photos nues sur la base de l'apprentissage automatique.

Encore une fois, Apple a des protections intégrées. Ce n'est que pour les photos de nus suspects. Elle n'affecte que les comptes enfants faisant partie des groupes familiaux. L'enfant est averti qu'un message entrant peut être inapproprié, puis choisit de le voir ou non. Aucun rapport externe n'est généré, seul un parent notifié le cas échéant.

Mais encore une fois, l'argument de la pente glissante est soulevé. Ce sont tous des contrôles qui s'appliquent actuellement, mais

l'EFF demande

Et si un gouvernement répressif obligeait Apple à changer les règles ?

L'organisation fait également valoir que les fausses correspondances sont un risque certain ici.

Encore une fois, ce n'est pas un problème avec la mise en œuvre actuelle d'Apple en raison des garanties incluses, mais la création d'une technologie capable d'analyser le contenu des messages privés présente un potentiel énorme d'abus futurs.

L'EFF met également en évidence un problème soulevé par certains experts en protection de l'enfance : qu'un parent ou un tuteur légal n'est pas toujours une personne sûre avec qui partager les messages privés d'un enfant.

Une partie de la discussion met en évidence que la corde raide délicate qu'Apple essaie de marcher. Par exemple, une protection est que les parents ne sont pas automatiquement alertés : l'enfant est d'abord averti, puis a le choix de voir ou non l'image. S'ils choisissent de ne pas le faire, aucune alerte n'est générée.

David Thiel

était l'un des nombreux à souligner le défaut évident :

Les mesures de protection des enfants d'Apple ne peuvent pas plaire à tout le monde

Tout le monde soutient ici les intentions d'Apple, et personnellement je suis entièrement satisfait du seuil de protection contre les faux positifs. Les autres garanties d'Apple sont également réfléchies et devraient être efficaces. L'entreprise doit être applaudie pour avoir essayé de résoudre un problème grave de manière prudente.

Dans le même temps, les risques de pente glissante sont bien réels. Il est extrêmement courant pour un gouvernement – même relativement bénin – de se laisser aller à la dérive missionnaire. Il introduit d'abord une loi à laquelle personne ne pouvait raisonnablement s'opposer, puis en élargit la portée, parfois à la manière d'un salami, une tranche à la fois. C'est particulièrement dangereux dans les régimes autoritaires.

A l'inverse, on pourrait affirmer qu'en rendant ce système public, Apple vient de faire un signe de la main. Désormais, toute personne ayant CSAM sur son iPhone sait qu'elle doit désactiver iCloud, et les agresseurs savent que s'ils veulent envoyer des nus à des enfants, ils ne doivent pas utiliser iMessage. Vous pourriez donc affirmer qu'Apple ne devrait pas du tout faire cela, ou vous pourriez affirmer qu'il aurait dû le faire sans le dire à personne.

La réalité est qu'il n'y a pas de solution parfaite ici, et chaque position qu'Apple pourrait adopter comporte à la fois des avantages et des risques.

Hier, avant que tous les détails ne soient connus, la grande majorité d'entre vous

opposé au mouvement

. Où en êtes-vous maintenant que les détails – et les garanties – sont connus ? Veuillez à nouveau participer à notre sondage et partager vos réflexions dans les commentaires.

Participez à notre sondage

Photo:

David Watkis

/

Unsplash

FTC : Nous utilisons des liens d'affiliation automatique qui génèrent des revenus.

Suite.

Découvrez 9to5Mac sur YouTube pour plus d'actualités Apple :

Vous lisez 9to5Mac, des experts qui annoncent jour après jour l'actualité d'Apple et de son écosystème environnant. Assurez-vous de vérifier

notre page d'accueil

pour toutes les dernières nouvelles, et suivez 9to5Mac sur

,

, et

pour rester dans la boucle. Vous ne savez pas par où commencer ? Consultez notre

histoires exclusives

,

Commentaires

,

Mode d'emploi

, et

abonnez-vous à notre chaîne YouTube

Guides

Société AAPL

Dernières nouvelles de Cupertino. Nous vous donnerons les dernières nouvelles du siège d'Apple et déchiffrerons les faits de la fiction du moulin à rumeurs.

Intimité

La confidentialité est une préoccupation croissante dans le monde d'aujourd'hui. Suivez toute notre couverture liée à la confidentialité, à la sécurité et plus encore dans notre guide.

Avis

A propos de l'auteur

Ben Lovejoy

@benlovejoy

Ben Lovejoy est un rédacteur technologique britannique et un éditeur européen pour 9to5Mac. Il est connu pour ses éditoriaux et ses journaux intimes, explorant son expérience des produits Apple au fil du temps, pour une critique plus complète. Il écrit également de la fiction, avec deux romans technothriller, quelques courts métrages de SF et une comédie romantique !

L'équipement préféré de Ben Lovejoy

NordVPN

Apple Watch série 3