Käyttämällä Adversarial Image Generation -tekniikoita taistelemme hyökkääjien käyttämiä uusimpia tietokonenäkömalleja vastaan. Käytämme tätä tekniikkaa kukistaaksemme hyökkääjien koneoppimismallit, pitäen samalla vaaditut pikselien muutokset mahdollisimman vähäisinä, jotta emme vaikuta hyvään käyttökokemukseen. Lue, miten se toimii.

Computer Vision antaa koneille näköaistin. Tekoälyn kehityksen ansiosta Computer Vision on kehittynyt huimaa vauhtia viime vuosina. Myös huijarit käyttävät laajalti autonomisten ajoneuvojen mahdollistanutta tekniikkaa kuvien automaattiseen indeksointiin ja luokitteluun sekä visuaalisen haasteen ja käyttäjän vuorovaikutusta vaativien verkkoturvajärjestelmien kukistamiseen.

Manipuloi hyökkääjien ML-malleja

Suojautuaksemme kehittyneitä koneoppimiseen perustuvia hyökkäyksiä vastaan Arkose Labsin valvontahaasteisiin olemme ottaneet käyttöön uuden kuvanluontitekniikan nimeltä Adversarial Image Sukupolvi. Käytämme tätä tekniikkaa puolustaaksemme joitain uusimpia hyökkääjien käyttämiä tietokonenäkömalleja. Käyttämällä tehokkaita häiriöitä tämä tekniikka kukistaa hyökkääjien koneoppimismallit ja pitää vaaditut pikselien muutokset mahdollisimman pieninä.

Me Arkose Labsissa näemme lukemattomia hyökkäyksiä. Puolustellaksemme niin monenlaisia hyökkäyksiä vastaan, luomme jokaiselle pulmalle useita kuvasarjoja. Jokaisella kuvasarjalla on yksilölliset asetukset, kuten erilaiset taustat, tyylit tai ohjeet. Nämä erilaiset asetukset auttavat huijaamaan hyökkääjiä kuvien erilaisella pikselien jakautumisella ja erilaisilla tuloksilla.

Koneoppimisalgoritmit ovat kuitenkin hyviä ennustamaan tietoja, joita he eivät ole koskaan nähneet. Tämän seurauksena nykyinen kuvanluontimenetelmä ei välttämättä aina toimi odotetulla tavalla. Siksi kehitimme uuden kuvanluontimenetelmän, joka lisää kuviin vastustavia häiriöitä manipuloidaksemme hyökkääjien kuvantunnistusta. Viimeaikaiset tutkimukset ovat osoittaneet, että syväoppivia malleja on helppo huijata kuvissa tietyllä kohinalla.

.

Kuva 1. Kilpailukykyinen häiriö (viite: https://arxiv.org/pdf/1906.00204.pdf)

Alunperin malli tunnistaa kuvan oikein. Kilpailevan kohinan lisääminen kuviin huijaa mallia täysin. Koneoppimismalli pystyi tunnistamaan alkuperäisen kuvan oikein jääkarhun kuvaksi, mutta huijautui näkemään sen astianpesukoneena kohinan lisäämisen jälkeen.

Voimme käyttää kontradiktorisen häiriön laskemiseen nopeaa gradienttipohjaista menetelmää ja optimointipohjaista menetelmää ensemble-lähestymistavan kanssa. Erilaiset tällä alalla tehdyt tutkimukset osoittavat, että on mahdollista siirtää ensemble-lähestymistavan synnyttämää häiriötä eri tietokonenäkömallien välillä. Tätä menetelmää käytetään kilpaileville kuville suojaamaan erilaisia koneoppimishyökkäyksiä vastaan.

Kuva 2. Vastakkaisten häiriöiden työnkulku

Kiistelykuvan luominen tapahtuu syklinä. Ensimmäinen askel on luoda vastustavia kuvia. Toinen vaihe on kouluttaa koulutetut mallit vastustavalla kuvalla. Koska hyökkääjät voivat harjoitella kilpailevien kuvien perusteella, virtaus tuottaa jatkuvasti vastustavia kuvia mallien kanssa, jotka on koulutettu erityisesti vastustaviin kuviin aiemmin. Tällä tavalla virtaus voi asettaa kohinan korkeammaksi ja kovemmaksi jokaisessa iteraatiossa.

"Hand Puzzle" -tapaustutkimus

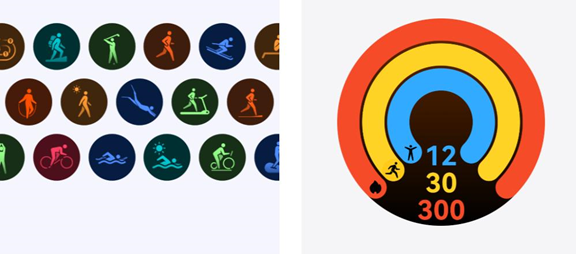

Jos haluat osoittaa vastustajakuvan puolustus- ja harjoitteluvahvuudet, tarkastellaan tapaustutkimusta, joka on kuvattu alla. Tämä tapaustutkimus on käsipalapeli, kuten kuvassa 3 näkyy. Oikeat kuvat ovat ne, joissa on yhteensä neljä sormea, loput ovat vääriä.

Aversarial häiriömenetelmä auttaa luomaan yhden oikeista kuvista, kuten alla olevassa kuvassa 4 näkyy. Ihminen ei välttämättä huomaa eroa kahden kuvan välillä, lukuun ottamatta hieman vaaleaa värjäytymistä toisen kuvan oikeassa alakulmassa. Koneoppimismalli ei kuitenkaan pysty tunnistamaan kuvaa ja luokittelemaan sitä virheelliseksi.

Kuva 3. Käsipalapelin tietojen visualisointi

Yllä olevan kuvan 4 ensimmäinen kuva on alkuperäinen kuva (oikea). Toinen kuva on kilpaileva kuva (virheellinen). Kolmas kuva näyttää eron alkuperäisen ja vastustajakuvan välillä. Viimeinen kuva on suurennettu ero kolmannesta kuvasta.

Puolustusvoima

Testaamme kuvia edistyneimmillä koneoppimismalleilla. Koulutamme nämä mallit sisäisesti hyvällä tarkkuudella. Tulokset ovat kuvan 5 mukaiset. Pelin tarkkuus kilpailevassa sarjassa laski noin 3 prosenttiin verrattuna vanhojen kuvien 8 prosenttiin.

Kuva 5. Vanhan ja vastakkaisen kauhan pelitarkkuus koneoppimishyökkäystä vastaan

Koulutusvoima

Teknisen osaamisensa vuoksi hyökkääjät voivat silti kerätä vastustavia kuvia ja kouluttaa koneoppimismalleja näille kuville. Pieni pikselimuutos vastustajaryhmissä voi helpottaa hyökkääjien harjoittelua, mikä voi olla huolestuttavaa. Kuva 6 osoittaa, että jopa pienellä pikselin muutoksella mallien on silti opittava uudelleen vastustavat kuvat.

Kuva 6. Näytekokokäyrä koneoppimiskoulutuksen uudesta ja kilpailevasta kauhasta

Tilannessa, jossa hyökkääjät voivat harjoitella kilpailevien kuvien perusteella, virtaus voi jatkuvasti lisätä kohinaa vastustavien kuvien päälle samoilla puolustus- ja harjoitusvahvuuksilla, kuten yllä on kuvattu.

Päihitä automatisoidut CAPTCHA:t haitallisilla häirinnöillä

Täällä Arkose Labsissa innovoimme jatkuvasti antaaksemme asiakkaillemme mahdollisuuden pysyä kehittyvien hyökkäystaktiikkojen edellä. Käytännössä kilpailevaa häirintää autamme heitä voittamaan automaattiset CAPTCHA-ratkaisijat ja suojelemaan liiketoimintaansa ja kuluttajia automaattisilta robottihyökkäyksiltä. Jos haluat oppia kuinka teemme tämän, varaa esittely nyt.

*** Tämä on Security Bloggers Networkin syndikoitu blogi Arkose Labsilta, kirjoittaja ChunLiang Wu. Lue alkuperäinen viesti osoitteessa: https://www.arkoselabs.com/blog/adversarial-perturbation-to-defeat-automated-captcha-solvers/